作者:徐英碩醫師

今天跟大家介紹一篇熱騰騰新出爐的 AI分析睡眠內視鏡 的文章,是由好朋友高榮耳鼻喉科蘇性豪主任所發表,真是台灣之光!

這篇文章分析了1000多個睡眠內視鏡的連續影像,試圖用人工智慧的方法分析這些影像,並進而叫電腦去計算,在這些連續影像之中,呼吸道的通暢程度。

特別的是,他們分析的內視鏡影像是有挑過的,特別針對有會厭軟骨出現的影像來分析。

由於我們的上呼吸道,由淺到深可能會發生阻塞的地方,包括軟顎、口咽、舌根、和會厭軟骨,所以這個研究分析的位置是屬於上呼吸道裡面最深的地方,也一般認為是比較難分析的地方。

為什麼要做睡眠內視鏡的人工智慧分析呢?因為現在睡眠內視鏡的影像判讀,判斷這些地方有沒有阻塞的根據,是靠人眼解讀,只能給個大概的阻塞程度,所以如果用人工智慧的方式,就能夠來看看能不能用電腦自動快速的分析這些影像的解剖構造和阻塞程度,甚至更好的情況,如果能夠做出一個連續的、實時的,根據影像中每秒不同程度的阻塞做出圖表的話,那就能夠讓我們臨床醫生很快速的判讀。如果再配合每一個不同位置,根據不同深度的影像和解剖構造,做出這種圖表,那我們醫生就可以很快地根據圖表,知道這一個病人的可能長達十幾分鐘時間的影像,到底是什麼地方阻塞,然後每個地方阻塞的程度又是怎麼樣,阻塞程度隨時間的變化,也就是阻塞的頻率又是怎麼樣,這樣就會有一個很快速清楚的認識,而且可以提供我們更多的數據做分析參考。

蘇主任這個研究選擇用會厭軟骨當作他們分析的目標,雖然會讓人覺得說:怎麼一開始就選呼吸道最深的地方來分析,但是看完整篇研究之後,會發現他做的其實非常有道理,因為會厭軟骨是整個上呼吸道構造裡面最有特色最明顯的東西!而有一個物件偵測的人工智慧訓練模型,剛好可以用來偵測會厭軟骨!這種人工智慧訓練模型的名字叫做YOLO (YOU ONLY LOOK ONCE),它的特色就是它可以分辨物體的種類,比如說這是一隻狗,這是一隻貓,這是一個人,他可以經由大量的訓練來辨認出來,這個圖片是貓而不是狗,是人而不是豬。YOLOv4第四版目前在Tesla V100的GPU上,使用MS COCO資料集,已經達到了接近65 FPS(每秒65幀)的表現,基本滿足實時檢測的需求。

利用YOLO這樣的能力,它可以在圖片中自動地把會厭軟骨的形狀識別出來,會厭軟骨在內視鏡底下看起來就是一個半月形的發亮的東西,非常有特色。相對來說,顎咽舌根扁桃腺這些東西可能就不是那麼好辨認,所以以這個研究先從辨認會厭軟骨入手。

找到會厭軟骨之後,他們再以會厭軟骨為中心,定義會厭軟骨周圍的一個範圍裡面的形狀,來決定會厭軟骨後面的呼吸道空間大小有多少。

在這邊他們又用了一個技巧,就是把內視鏡裡面顏色的精細度降維,比如說說有250色階的內視鏡影像變成只有六個色階,讓呼吸道的輪廓變得更清晰,更容易被人工智慧來識別出來。

藉由先辨認會厭軟骨的位置,用會厭軟骨的中心點為基準,把會厭軟骨和周圍框起來,然後用降低色階的方式,讓會厭軟骨後方空氣氣道的輪廓更清楚,再用模糊化的方式,把空氣道的輪廓變得更平整,避免因為偵測到更深一層的解剖構造,如杓狀軟骨和會厭杓狀軟骨皺嬖(AE fold),而低估了空氣道的大小。

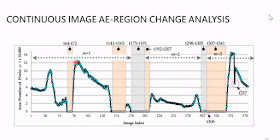

最後蘇主任團隊根據這樣估計出來的空氣道大小,以時間為橫軸,空氣道大小為縱軸,就可以做出睡眠內視鏡中,會厭軟骨部分的呼吸道空間,隨時間變化的圖表,清楚的顯示出,睡眠呼吸中止症病人因為會厭軟骨阻塞而造成的,隨時間不同的呼吸道阻塞變化!

徐醫師評論:我本人跟陽明交大鐘翊方教授也在做睡眠內視鏡的人工智慧分析,不過我用的是segmentation 的方法,也就是需要先人工標註出我們想要人工智慧偵測到的呼吸道範圍,然後經過訓練,再讓人工智慧去判讀,看看能不能經由訓練,讓人工智慧學會辨認呼吸道的空間。而我們針對的解剖構造是比較淺的顎咽,而這個地方也是相對來說最容易發生阻塞的部位,有九成的睡眠呼吸中止都是這個位置的阻塞造成,而會厭軟骨的阻塞大概只佔15%左右。而我們的研究成果在今年10月也有到美國耳鼻喉科學會報告,我們發現就顎咽阻塞的阻塞空間呼吸道大小的判讀方面,AI可以達到9成以上的呼吸道空間面積判讀準確率,只是現階段我們還在努力收集資料,做更多的影像標注,看看能不能把模型訓練的更好,所以目前還沒發表。

看到蘇主任率先攻頂成功,除了恭喜他,我們也學到很多,包括將來可以考慮使用他們的YOLO 方法,來試試看辨認比較困難的下咽構造,以及學習他們使用時間為橫軸,阻塞程度為縱軸的方式,來呈現我們的研究結果。有了他們的成功經驗,我也對我們團隊將來的研究方向充滿信心,相信將來很快也會有不錯的全國跟大家報告!

蘇主任的回響:謝謝徐大師的講評,寫得真是太好了! 大推!

惟就後學個人的DISE經驗,

Epiglottis部位發生complete obstruction (collapse >75%)的機會高於50%,

絕對不僅僅只有15%,

在我眼中是一個不容忽視、需要處理的區域喔。

這次之所以選擇epiglottis影像做研究,

一方面發生率高,一方面的確如英碩兄所言,

形狀(特徵)很好認、適合YOLO辨識學習。

不同AI工具各有其所長,

可以跟研究團隊好好討論,

應用在適合的情境。

期待大家迸出更多創意的火花!